Les algorithmes sont devenus omniprésents dans nos vies de plus en plus connectées. Ils nous aident à choisir une musique, une recette, un partenaire, un placement, un hôtel, etc. C’est encore eux qui aident les institutions à prendre des décisions de justice, le médecin à poser son diagnostic, le trader à spéculer ! Ils suggèrent, ils guident, ils informent, ils classent. Tous les secteurs sont impactés, logistique, santé, éducation, recherche, défense, banque, agroalimentaire, culture, loisir. Or, même si les algorithmiques sont vecteurs d’amélioration des activités, ils ont intrinsèquement des limites, notamment éthiques. Cette contribution est centrée sur la mise en perspective de ces questionnements éthiques qui apparaissent de plus en plus complexes notamment au regard de leur imbrication croissante (Mason, 1986 ; Hamet et Michel, 2019).

Des algorithmes aux systèmes algorithmiques

Il est assez délicat de donner une caractérisation précise de ce qu’est un algorithme (https://www.lebigdata.fr/algorithme-definition-tout-savoir ). À l’origine, la notion d’algorithme fait référence à une suite d’instructions ou d’opérations élémentaires permettant de résoudre un problème. Aujourd’hui, ils sont présentés comme une séquence finie d’instructions décrivant en détail comment résoudre un problème. Mais, pour définir de façon pertinente un algorithme, il faut aller au-delà des aspects techniques, et tenter d’ouvrir la « boite noire ». Dans ce sens, Seaver (2017), définit les algorithmes comme des systèmes sociotechniques diffus et hétérogènes, plutôt que des procédures fixes et rigides, ce qui signifie que ce n’est pas l’algorithme seul qui peut poser des problèmes, mais bien son imbrication dans un système, un jeu d’acteurs, de normes de pouvoir, de complexité.

La complexité des questionnements éthiques imbriquées

Quid de l’équité et de la question des biais ?

Les algorithmes sont chargés de valeurs, de normes qui peuvent aller des injonctions morales à des normes silencieuses intégrées inconsciemment. Ils ne sont rien d’autres que des idées, des opinions formalisées plus ou moins correctement dans du code. Ils n’échappent en rien – dès leur conception – à la subjectivité des développeurs, des managers, des donneurs d’ordre, de la société et de ses stéréotypes.

Les valeurs intégrées par les concepteurs/développeurs dans les systèmes algorithmiques, posent un problème éthique dans le sens où ils imposent un comportement prédéterminé, car ils peuvent contenir des biais renforçant les préjugés, comme des biais raciaux, de genre et, car ils peuvent s’appuyer sur des données collectées erronées. C’est une problématique cruciale avec l’intelligence artificielle (https://www.lebigdata.fr/intelligence-artificielle-et-big-data), puisqu’une machine est capable d’apprendre au travers de son propre traitement de données.

Aussi, dans les années 2000, une importante question a émergé dans la littérature, sous le terme de social sorting (https://en.wikipedia.org/wiki/Social_sorting ). Ce courant étudie le risque que l’analyse des données personnelles n’aboutisse à une ségrégation ou à une discrimination. Les employeurs, comme les banques, compagnies d’assurances, agences immobilières et bailleurs sociaux n’hésitent plus à utiliser des algorithmes de tri-social. Les algorithmes n’ont pas inventé la discrimination, mais ils y participent en la reproduisant, voire en l’intensifiant.

Quid de la responsabilité ?

Il existe une tendance regrettable à renoncer à attribuer des responsabilités lorsqu’il s’agit des algorithmes, renoncement qui provient de deux sources. La première est ce que De George désigne par le mythe des TIC amoraux, qui revient à limiter les TIC à leur aspect technique, et à considérer que les machines ne peuvent, à l’évidence, être tenues responsables des conséquences de leur utilisation. La seconde source de dilution de responsabilité provient d’une scission, dans la prise de décision, entre les développeurs, qui estiment remplir leur devoir en respectant strictement les demandes qu’ils reçoivent, et le management, qui ne s’estime pas responsable des failles liées à la technologie.

Quid de la transparence et son versus « l’expertise » ?

Les algorithmes, de par la multiplicité des acteurs, des parties prenantes sont de plus en plus opaques. Or, la transparence de ces outils est une demande forte des individus en lien avec la protection de leur vie privée, la confidentialité des données stockées, et le droit à l’oubli par exemple.

Aussi, le problème éthique lié à cette transparence peut nous mener à des questionnements plus larges. A tire d’exemple, dès les années 1960, certains se sont inquiétés du fait que les progrès scientifiques et technologiques pouvaient menacer le fonctionnement de la démocratie, car seuls quelques experts étaient capables de comprendre réellement les technologies complexes. Puis, après les experts, le système algorithmique pourrait aussi aboutir à une forme de gouvernementalité algorithmique fondée sur le traitement statistique de la multitude de données communiquées (volontairement ou non) par les citoyens eux-mêmes. (https://nouvelles.umontreal.ca/article/2018/11/27/les-algorithmes-des-risques-pour-la-democratie/)

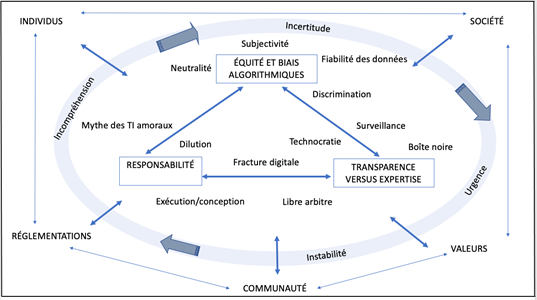

Conclusion et mise en perspective cartographique

Le schéma ci-dessous résume notre propos. Nous y présentons une cartographie de la complexité des questions éthiques.

L’enjeu des années à venir est de garder à l’esprit non pas l’impératif d’une éthique mais plutôt la complexité de cette exigence légitime.

Sylvie Michel, Sylvie Gerbaix et Marc Bidan

Références

De George, R. T. (1999). Business ethics and the information age. Business and Society Review, 104(3), 261-278.

Hamet, J., & Michel, S. (2018). Les questionnements éthiques en systèmes d’information. Revue française de gestion, 44(271), 99-129.

Mason R.O. (1986). Four Ethical Issues of the Information Age. MIS Quarterly, 10 (1), 5-12.

Seaver, N. (2017). Algorithms as culture: Some tactics for the ethnography of algorithmic systems. Big data & society, 4(2), 2053951717738104.