Force est de constater que la frontière entre les domaines des capacités humaines et celles des machines subissent des modifications profondes, notamment avec la montée en puissance de l’intelligence artificielle (IA) générative qui tente d’imiter parfaitement la « pensée pensante » originellement de nature humaine, ce qui engendre un enchevêtrement dans les attributions respectives de l’homme et de la machine. Cet article tente d’apporter un regard original et utile quant à la modification des frontières entre les domaines des capacités humaines et des capacités des machines, et ce en ayant recours aux apports de la philosophie de la technologie telle que conçue par Paul Virilio. Ce philosophe invite à considérer notre capacité à penser par nous-même, loin de la délégation faite pour des machines de plus en plus puissantes. Selon Virilio, la trajectoire des développements technologiques est marquée par un déplacement des capacités décisionnelles de l’homme de toutes les sphères de la vie sociale vers les machines, car la pensée humaine est devenue trop lente, comparée à la vitesse des machines.

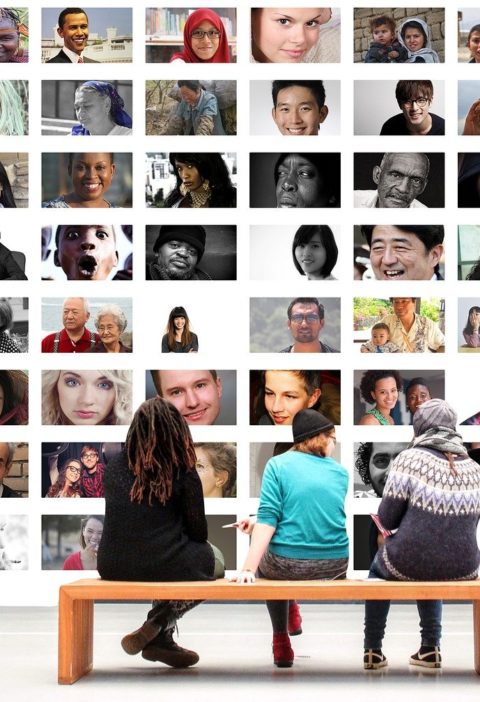

Avec l’arrivée de l’IA, le travailleur s’installe dans le temps en convertissant la société de persistance en une « société de la disparition » (Virilio, 1989), où la territorialité est remplacée par la temporalité. Casilli (2019) illustre bien cette idée « d’aliénation radicale » des tâcherons du clic « qui œuvrent inlassablement à leur propre disparition en s’effaçant derrière les machines dont ils sont et resteront les rouages indispensables » (p.305). L’IA cache « une myriade d’assistants invisibles » qui sont délibérément invisibilisés par les « machines de vision » au sens de Virilio qui cherchent à entretenir le mythe d’une IA magique entièrement automatisée en passant sous silence le travail humain de la donnée que cela représente. Dans son ouvrage « l’horizon négatif », Virilio (1984) explique que la « machine de vision » fait référence à la technologie moderne, notamment les caméras, les satellites et d’autres dispositifs de surveillance, qui ont transformé notre façon de percevoir et de comprendre le monde. Les Machines de l’IA produisent un réseau global où toutes les surfaces du globe sont directement présentes l’une à l’autre, cette déterritorialisation fournit les conditions d’un nouvel espace technologique qui n’est pas géographique mais « vitesse-espace » source de disruption de la perception. En effet, les individus se trouvent projetés dans un autre espace dans lequel ils ne peuvent maintenir leur position que par le moyen de réseaux complexes d’instruments de mesures et de « prothèses de la perception » (Virilio, 1984). Ces prothèses conduisent à une déréalisation où les anciens champs de perception sont détruits par une surproduction de mouvements. L’utilisation de l’IA et du métavers permet de constituer un univers qui englobe et interconnecte plusieurs mondes numériques, plateformes et expériences. Il permet de créer des espaces immersifs et interactifs, dans lesquels les utilisateurs peuvent se déplacer, communiquer, créer et explorer ces environnements numériques en utilisant des avatars. La relation symbiotique entre l’homme et les Machines de l’IA a des répercussions tant au regard de la perception portée envers ce qui nous entoure que par rapport à la perception de nous-mêmes. A titre d’exemple, Giroux et al., (2022) expliquent que la nature non humaine de l’interaction induit les hommes à moins percevoir de sentiment de culpabilité en réduisant le raisonnement éthique et le comportement moral. Visant à accroître les perceptions humaines, l’anthropomorphisation est de nature à renforcer « les prothèses de perception », faussant et biaisant la vraie perception des choses et de nous-mêmes ; cela aura des répercussions aussi bien identitaires qu’existentialistes.

Plusieurs informaticiens et spécialistes en systèmes d’information soulignent la nécessaire prise en compte du fait que le design algorithmique qui sous-tend les Machines d’IA n’est pas objectif ni neutre mais puise plutôt ses sources dans des suppositions normatives de nature à porter préjudice aux catégories les plus vulnérables telles que les femmes, les personnes en situation de handicap et les minorités ethniques. Le scandale de l’attribution des allocations familiales aux Pays-Bas où des familles ont été faussement accusées de fraudes est un exemple de la gravité des violations « accidentelles » que pourraient commettre les algorithmes d’IA. En effet, faisant le tri à l’aide de données en ligne, les algorithmes mis en place par l’administration fiscale néerlandaise ont généré un profil de suspect type : une personne vivant dans un quartier populaire, ayant plus de deux enfants. Par un raccourci statistique, ces algorithmes se sont concentrés sur les couples binationaux auxquels des aides ont été attribuées avant qu’elles ne soient brutalement supprimées, sans forcément effectuer les vérifications nécessaires. L’administration fiscale néerlandaise a plongé dans la détresse des dizaines de milliers de familles, notamment, des mères d’origine étrangère, en leur réclamant indûment des sommes faramineuses. Pendant près de quinze ans, les autorités néerlandaises ont pourchassé à tort 30000 familles, souvent modestes et issues de l’immigration, pour obtenir un remboursement de leurs aides. Les conséquences de cet accident sont à la fois sociales, financières (un désastre pour les foyers entraînant des dettes et des séparations) et politiques (l’État s’est avéré incapable de réparer l’erreur produite par une machine d’IA et le gouvernement a démissionné en 2021). Cet exemple illustre bien l’idée de « l’accident des accidents » ou la spirale infernale d’accidents déclenchés suite à une erreur commise par la Machine d’IA et qui échappe complètement au pouvoir de l’homme.

L’IA est de plus en plus intégrée dans les entreprises afin de favoriser la collaboration homme-machine et d’aider les employés dans leurs tâches professionnelles. Cependant, l’introduction de l’IA peut avoir un impact négatif sur la façon dont les employés s’identifient à leur travail. Elle modifie fondamentalement les espaces de travail en valorisant les réseaux électroniques et le cloud et les temps de travail en accélérant le traitement des tâches, ce qui alimente les craintes des individus d’être remplacés. Un des défis que pose l’IA est que cette technologie bouleverse la perception que les utilisateurs ont d’eux même et de leur identité professionnelle. Cette « pollution grise », par les ruptures qu’elle crée dans l’espace et dans le temps de travail, invite à poser la question suivante : Qui suis-je lorsque j’interagis avec les Machines d’IA en milieu de travail ? Suis-je encore nécessaire ? ou serai-je remplacé, dans un avenir proche, par une Machine d’IA qui soit plus rapide et plus performante que moi ? Cette menace identitaire découle du fait que les frontières entre l’Homme et la machine d’IA soient aujourd’hui brisées générant une pollution qui interpelle de plus en plus les chercheurs.

Rim Hachana et Patrick Gilormini

Références

Casilli, A.A. (2019). De la classe virtuelle aux ouvriers du clic. La servicialisation du travail à l’heure des plateformes numériques. Esprit, 5, 79-88.

Giroux, M., Kim, J., Lee, J. C. & Park, J. (2022). Artificial intelligence and declined guilt: retailing morality comparison between human and AI. Journal of Business Ethics, 178, 1027-1041.

Virilio, P. (1984). L’horizon négatif, Galilée. Paris.

Virilio, P. (1989). Esthétique de la disparition. Galilée, Paris.